Formation ChatGPT gratuite

Découvrez les meilleures formations gratuites pour maîtriser l’art du prompt engineering et devenir un pro de ChatGPT et des autres modèles d’IA générative !

Nous et nos partenaires utilisons des cookies et des traceurs pour :

Téléchargez le syllabus

Téléchargez le rapport d’insertion 2025

ChatGPT est un agent conversationnel basé sur l’IA générative, basé sur un modèle de langage de type GPT (Generative Pre-trained Transformer). Derrière ChatGPT, qui a été créé par OpenAI, se cache ainsi un programme qui s’appuie sur une vaste base de données pour générer du contenu qui réponde de manière cohérente à vos questions ou à vos instructions. À la date de mai 2025, ChatGPT est ainsi en mesure de générer du texte, mais aussi des images, du code et même des vidéos.

Lancé en novembre 2022, ChatGPT a rapidement su conquérir son public et fait partie de l’histoire de l’IA moderne. Pour preuve : en février 2025, la plateforme comptait plus de 400 millions d’utilisateurs actifs de manière au moins hebdomadaire. Pour vous donner un ordre d’idée, c’est presque 6 fois la population de la France !

ChatGPT doit son succès à plusieurs facteurs :

Une technologie qui sait répondre à vos questions, même les plus complexes, est forcément intelligente non ? Eh bien, pas vraiment ! Bien que ChatGPT puisse donner l'impression d'intelligence, il est important de comprendre qu'il ne possède ni conscience, ni compréhension réelle. Et s’il peut vous répondre de manière efficace, c’est avant tout grâce à ses algorithmes qui se basent sur de nombreux critères.

Pour faire simple, ces algorithmes ont été entraînés sur d’immenses quantités de données différentes. En les analysant, le modèle a appris à repérer des schémas récurrents dans la manière dont les humains s’expriment.

C’est ce travail d'observation à grande échelle qui lui permet ensuite de prédire le mot le plus probable dans une phrase donnée, en fonction du contexte. Pas besoin de comprendre : il lui suffit de calculer ce qui « colle » le mieux au contexte statistiquement.

Autrement dit, ChatGPT simule l’intelligence, mais ne réfléchit pas. Ce n’est pas un cerveau, c’est un miroir textuel de ce qu’il a appris.

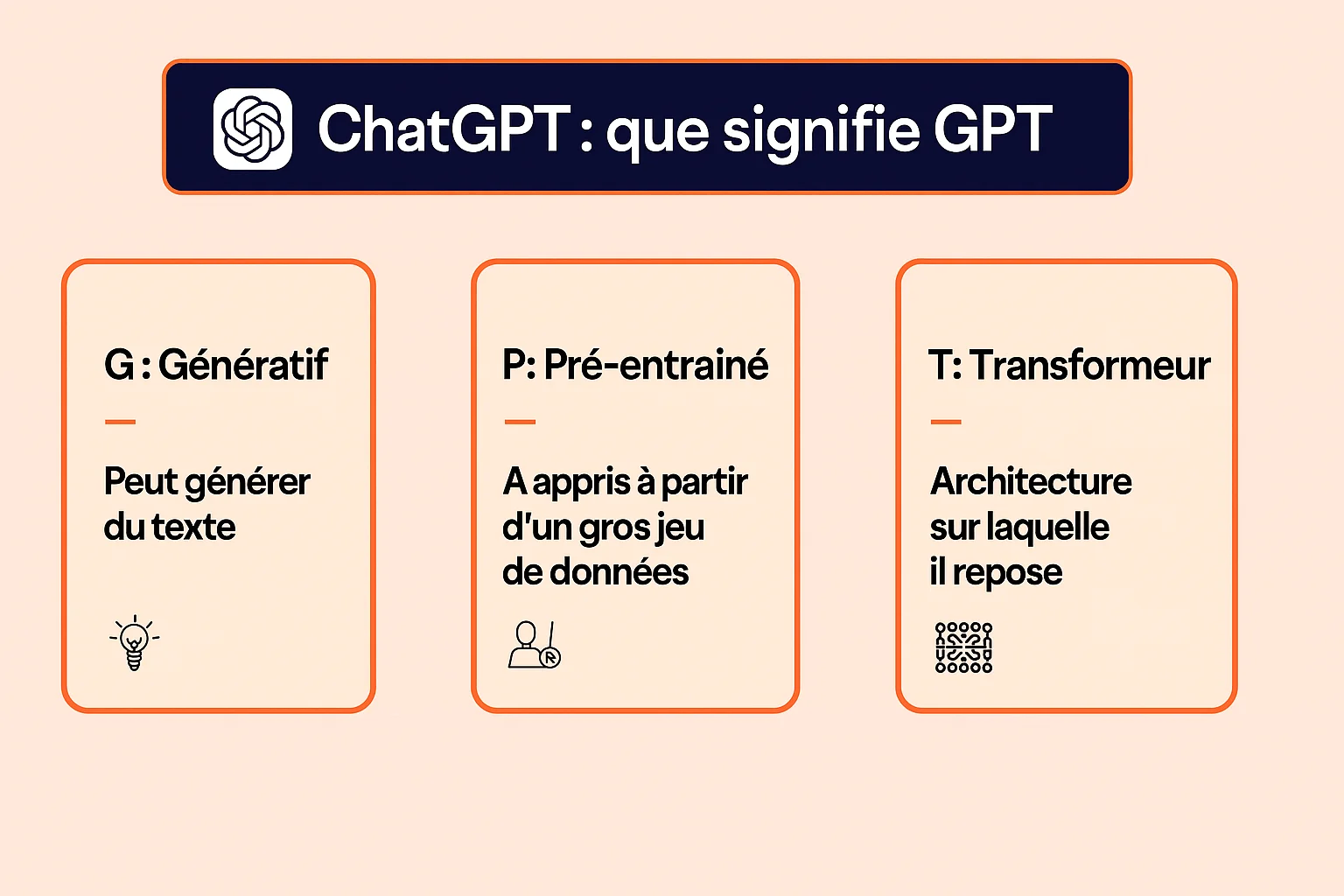

Vous vous êtes probablement déjà demandé pourquoi ChatGPT s’appelait « ChatGPT ». Si le début de ce nom se réfère à la qualité d’agent conversationnel de cette technologie, la fin, elle veut dire quoi ? Eh bien « GPT » est en réalité un acronyme qui signifie « Generative Pre-trained Transformer ». Continuez à lire pour découvrir les significations de ces mots 👇

Generative, ou « génératif » en français, signifie que ChatGPT ne copie pas, il invente à la volée. Son travail, c’est de créer du texte mot après mot, et pour cela, il part de ce que vous lui avez dit ou demandé pour déterminer quelle est la suite la plus probable statistiquement.

Par exemple, imaginons que vous demandiez à ChatGPT quelle est la capitale de l’Italie. Pour vous répondre, ChatGPT ne va pas chercher une réponse préenregistrée, et pour cause : il est techniquement impossible d’imaginer toutes les questions que nous pourrions lui poser et de prévoir pour chacune d’elles des réponses adaptées. Et si nous faisions cela, l’intelligence artificielle perdrait même de son intérêt. Mais comment fait ChatGPT pour vous répondre alors ? Il va générer le mot « Rome », car d’après les millions de textes qu’il a analysés, c’est la réponse la plus logique à votre question.

Ce fonctionnement explique par ailleurs pourquoi les algorithmes peuvent souffrir de biais algorithmiques, qui sont en réalité le reflet des biais humains qui étaient présents dans les bases de données sur lesquelles ChatGPT a été entraîné.

Pre-trained signifie que le modèle a été entraîné sur des milliards de données différentes pour pouvoir générer ses réponses (livres, Wikipédia, sites web, images…). Cela lui a permis de détecter des patterns comme les suites de mots les plus probables dans un contexte donné (souvenez-vous de notre exemple avec Rome). Il se base ainsi sur les statistiques issues de son entraînement pour générer des réponses cohérentes.

Pour comprendre, imaginez un étudiant qui aurait dévoré toute la bibliothèque de sa faculté, et réussi à retenir l’intégralité de ce qu’il avait lu. Avant ses examens, il n’aurait même pas besoin de relire ses cours pour se préparer, puisqu’il aurait déjà assimilé une masse colossale de connaissances qu’il saurait restituer au bon moment pour réussir ses épreuves.

Transformer est le nom de l’architecture utilisée par ChatGPT. Sa grande force ? Elle permet au modèle d’analyser tous les mots d’une phrase en même temps, et non pas un par un comme avec les anciens systèmes.

Mais surtout, cette architecture repose sur un mécanisme d’attention. Pour simplifier, le modèle calcule à quel point il doit « faire attention » à chaque mot. Il détermine ainsi lesquels sont les plus importants à prendre en compte, pour bien traiter votre requête. C’est un peu comme lorsque vous êtes en train de discuter dans une salle bondée : pour bien entendre votre interlocuteur, vous vous concentrez sur sa voix et filtrez les bruits autour.

Prenons un exemple pour que vous compreniez mieux : dans « Le gâteau que tu as préparé est délicieux », ChatGPT va attribuer un poids d’attention plus élevé aux mots « gâteau » et « délicieux », ce qui lui permet de faire le lien entre eux, même s’ils sont éloignés dans la phrase.

Si aujourd’hui, ChatGPT est capable de générer des réponses bluffantes de pertinence, il n’en a pas toujours été le cas. Sa capacité à tenir une conversation fluide et naturelle est en réalité le fruit d’un long processus d’entraînement qui a combiné Big Data, supervision humaine et retours utilisateurs.

Pour fonctionner, ChatGPT a tout d’abord été exposé à des milliards données, notamment textuelles (livres, articles, pages web, scripts, etc.), dont il a analysé la structure pour repérer les enchaînements de mots les plus fréquents. L’objectif ? Lui apprendre à prédire le mot suivant dans une phrase, non pas en comprenant le sens comme un humain, mais en se basant sur des calculs statistiques.

L’un des gros points forts de cet apprentissage, c’est qu’il se fait sans intervention humaine : c’est ce qu’on appelle un apprentissage non supervisé, qui permet aux modèles sur lesquels ChatGPT est basé de découvrir les règles du langage naturel sans que personne ne les leur explique.

Mais savoir écrire des textes statistiquement probables, ce n’est pas suffisant. Pour être réellement efficace, ChatGPT doit aussi savoir s’adapter à son interlocuteur. C’est là qu’intervient la deuxième étape de son entraînement : le Supervised Fine-Tuning.

Des humains (souvent des chercheurs ou des ingénieurs en Machine Learning ou en intelligence artificielle) fournissent à ChatGPT des exemples de questions-réponses bien construites, formulées avec le même ton que celui que l’IA doit apprendre à utiliser. Le ton peut être pédagogique, humoristique, technique, adapté à un métier spécifique, les seules limites, ce sont celles de votre imagination !

Le modèle analyse ensuite ces questions-réponses pour apprendre à formuler des réponses compréhensibles, et surtout, pour adapter son ton et son style à vos besoins. En bref : il apprend à être compréhensible, et pas juste à aligner des mots qui, mis ensemble, peuvent parfois manquer de sens.

L’entraînement de ChatGPT se conclut par ce que l’on nomme l’apprentissage par renforcement à partir de rétroaction humaine, abrégé RLHF (pour l’anglais (Reinforcement Learning from Human Feedback). Les humains interviennent à nouveau, non pas pour fournir des réponses types, mais pour noter celles produites par l’intelligence artificielle. Ils peuvent également être amenés à analyser plusieurs réponses fournies pour une même question, afin de déterminer laquelle est la plus pertinente, la plus claire ou la plus utile.

Ces retours sont précieux au modèle LLM, puisqu’ils lui permettent d’intégrer les préférences utilisateurs à ses paramètres. Résultat : il peut alors affiner son style, ses formulations, ou même son niveau de détail.

Et ce n’est pas tout : cet apprentissage n’est pas limité dans le temps, permettant au modèle de s’améliorer petit à petit, génération après génération.

Vous avez sans doute déjà été bluffé par la rapidité et la pertinence des réponses de cette IA générative. Mais ChatGPT, comment ça marche ? Que se passe-t-il en coulisses lorsque vous envoyez à l’IA une question comme « Quelle est la couleur du ciel ? » ?

Spoiler : même si on dirait, ce n’est pas de la magie, juste de la science et pas mal de maths.

ChatGPT fonctionne en découpant votre question en petits morceaux nommés des tokens. Cette étape s’appelle la tokenisation, et elle joue un rôle central dans le traitement automatique du langage naturel, aussi appelé NLP (Natural Language Processing). En clair, c’est le point de départ qui permet à l’IA de transformer du texte humain en quelque chose qu’elle peut analyser mathématiquement.

Cette tokenisation a ainsi lieu pour plusieurs raisons, et elle permet notamment de :

Un token peut être un mot entier, une syllabe ou même un bout de mot. Ce découpage est la base du traitement du langage naturel.

Pour reprendre notre exemple, la phrase « Quelle est la couleur du ciel ? » est tokénisée en « Quelle / est / la / couleur / du / ciel / ? ». Autre exemple, le mot « cyberattaque » est lui divisé en 2 tokens : « cyber / attaque », permettant à ChatGPT de comprendre chaque partie séparément puis d’associer leurs significations :

Chaque token est ensuite converti en une suite de nombres appelée vecteurs. Cela revient un peu à traduire les mots dans une langue que la machine comprend : le langage mathématique.

Le mot « ciel » de notre exemple pourrait ainsi être transformé en quelque chose comme [0.12, -1.03, 0.88, ...]. (Notez que cette réponse est volontairement simplifiée, car en réalité, ces vecteurs peuvent contenir des centaines de dimensions numériques.)

Pourquoi faire tout ça ? Parce que ChatGPT ne comprend pas les mots tels quels. Son truc à lui, c’est de traiter des chiffres. Ces vecteurs lui permettent ainsi de calculer les relations entre les mots pour détecter des similitudes, et analyser le contexte global de votre requête.

Autrement dit, ChatGPT ne lit pas vos phrases : il les décrypte en cartographiant mathématiquement leur sens pour tenter de prédire la réponse la plus adaptée à vos besoins.

Une fois la question traduite en vecteurs, ChatGPT réfléchit (enfin, façon de parler). Grâce à son entraînement sur des milliards de phrases, il a appris à repérer les suites de mots les plus probables, en fonction du contexte. Si vous demandez « Quelle est la couleur du ciel ? », ChatGPT ne consulte pas une fiche réponse, mais calcule que dans 99 % des cas, le mot « bleu » suit logiquement cette question. Donc, c’est le mot qu’il génère.

Une fois que ChatGPT a prédit chaque mot un à un, il ne lui reste plus qu’à les assembler pour former une phrase complète et cohérente. Chaque prédiction est en fait comparable à une brique posée sur la précédente. Le modèle construit ainsi sa réponse mot après mot, en prenant toujours en compte le contexte déjà généré.

Reprenons une dernière fois notre exemple. Après avoir découpé, traduit et prédit sa réponse, ChatGPT la génère en temps réel et vous répond « Le ciel est bleu. ». Pour vous, sa réponse est presque instantanée, mais en coulisses, ce sont des milliers de calculs qui viennent de s’enchaîner en seulement quelques millisecondes !

Et ce processus, ultra-rapide, se répète pour chacune de vos questions.

ChatGPT ne dort jamais. Depuis son lancement, il ne cesse d’apprendre, d’évoluer, de s’améliorer. À chaque nouvelle version, les modèles de ChatGPT deviennent plus rapides, plus intelligents, et même plus polyvalents.

Jusqu’à récemment, ChatGPT se limitait à l’analyse du texte. En gros, vous ne pouviez que lui envoyer vos questions par écrit. Mais aujourd’hui, il est multimodal : il peut comprendre et répondre à des instructions données sous forme de texte, d’image ou même via la voix.

Ainsi, vous pouvez désormais partager une photo à ChatGPT et lui demander de vous la décrire. Vous avez également la possibilité de converser avec ChatGPT de vive voix, et d’obtenir des réponses à l’oral, quasiment en instantané.

Mais qu’est-ce qui a rendu possible ces évolutions ? La réponse est simple : un entraînement spécifique sur des données multimodales (des textes liés à des images, des vidéos sous-titrées, des fichiers audio transcrits…). ChatGPT a ainsi appris à faire le lien entre différents types d’informations, comme le ferait un cerveau humain.

Mai 2024 a marqué une avancée majeure dans l'histoire de ChatGPT, puisque c'est à cette date qu'OpenAI a lancé le premier de ses modèles o-series. Depuis, plusieurs nouveaux modèles sont venus étoffer cette collection, chacun répondant à des besoins spécifiques :

GPT-5 : La révolution d'août 2025 unifie toutes ces avancées. Devenu le modèle par défaut pour tous les utilisateurs, GPT-5 intègre les forces de ses prédécesseurs dans un système unique qui adapte automatiquement son niveau de raisonnement selon vos besoins. Plus besoin de choisir : il combine la rapidité de GPT-4o, la créativité de GPT-4.5 et la logique de GPT-o3, tout en réduisant drastiquement les hallucinations et en étendant le contexte jusqu'à 196 000 tokens en mode Thinking.

Les modèles ChatGPT ne cessent ainsi de s'améliorer, et se rapprochent même petit à petit de l'AGI (un type d'IA doté d'un niveau de raisonnement comparable à celui des humains).

Si vos besoins sont très spécifiques, les réponses de ChatGPT pourraient vous décevoir. Et pour cause : il a été entraîné pour répondre à une grande variété de questions, avec un ton accessible et des formulations claires. C’est ce qui fait sa force, mais aussi parfois sa faiblesse, car ses réponses pourront manquer de précisions par rapport à votre métier, ou ne pas employer le vocabulaire technique adapté.

Mais heureusement, plusieurs méthodes vous permettront de personnaliser ChatGPT pour qu’il vous fournisse des réponses alignées à vos besoins.

Le Prompt Engineering, c’est l’art de bien parler à l’IA. Plus vos instructions sont claires et détaillées, plus ChatGPT vous donnera une réponse pertinente.

Imaginons que vous êtes sophrologue, et que vous demandiez de l’aide à ChatGPT pour construire votre calendrier éditorial :

Qu’est-ce qui a changé ? Vous avez cadré l’IA en lui donnant un rôle, un contexte et une cible, ce qui lui a permis de cerner au mieux vos besoins.

Astuce pour ChatGPT : vous pouvez utiliser des exemples de prompts, ou même un générateur de prompt pour vous aider à construire des prompts réellement efficaces.

Le Fine-Tuning, c’est l’étape au-dessus du Prompt Engineering : vous n’ajustez plus juste la consigne, vous réentraînez ChatGPT avec vos propres données, pour qu’il s’adapte parfaitement à votre métier, à votre ton, à vos cas d’usage.

Imaginons que vous soyez juriste ; vous pourriez alors fine-tuner ChatGPT pour qu’il vous réponde en utilisant le vocabulaire juridique que vous utilisez vous-même au quotidien.

Bien que cette technique soit un peu plus complexe à mettre en place, elle est très intéressante, car elle vous permet de créer un assistant sur mesure, sans avoir à développer un modèle de toutes pièces.

Avec l’arrivée de modèles comme GPT-5, ChatGPT s’impose aujourd’hui comme l’un des agents conversationnels les plus avancés au monde. Mais concrètement, qu’a-t-il de plus que les autres LLM ?

Aussi impressionnant qu’il soit, ChatGPT reste une machine avec des défauts :

S’il peut ainsi parfois donner l’illusion de tout savoir, veillez à toujours garder un œil critique et à vérifier ses réponses !

Vous êtes désormais incollable, ou presque, sur le fonctionnement de ChatGPT. Et si vous alliez plus loin en rejoignant notre formation ChatGPT complète et éligible au CPF ? D’une durée de 42 heures, cette formation est conçue pour vous permettre d’exploiter les IA génératives comme ChatGPT à leur plein potentiel. Vous y découvrirez notamment l’art du Prompt Engineering, et apprendrez à personnaliser les modèles IA pour qu’ils répondent à vos besoins, quel que soit votre domaine.

Vous voulez en savoir plus ?

Oui, ChatGPT applique des filtres de sécurité pour éviter les réponses toxiques, violentes, discriminatoires ou inappropriées. Cette modération est intégrée directement dans son fonctionnement pour garantir un usage responsable.

Si vous voulez éviter cette censure, vous pouvez essayer de la contourner en jailbraikant ChatGPT, ou encore tester l’un de ses concurrents.

Un paramètre est un peu comme un petit bouton de réglage interne que le modèle ajuste pendant son entraînement pour mieux comprendre et générer du langage. Ainsi, plus un modèle possède de paramètres, plus il est capable de traiter des tâches complexes.

Historiquement, GPT-3.5 utilisait environ 175 milliards de paramètres, et GPT-4 possédait entre 1 000 et 1 700 milliards de paramètres selon les estimations. Pour les modèles récents comme GPT-4o, GPT-o3 et maintenant GPT-5.1, OpenAI n'a jamais communiqué officiellement sur leur nombre de paramètres.

Mais ce qu'il faut retenir, c'est que le nombre de paramètres ne fait pas tout : GPT-5 prouve que l'architecture et les méthodes d'entraînement comptent autant que la taille brute. Ses performances exceptionnelles résultent d'innovations dans la gestion du contexte, l'adaptation dynamique du raisonnement et l'intégration multimodale, plutôt que d'une simple augmentation du nombre de paramètres.

ChatGPT est principalement développé en Python, avec le framework PyTorch qui permet son entraînement et le fonctionnement de ses réseaux de neurones. Cet entraînement, qui implique d’immenses quantités de données, est facilité grâce à des outils comme Pandas et NumPy qui facilitent le traitement de ces données.

Enfin, ChatGPT s’appuie également sur du C++ pour accélérer ses calculs, et sur du Javascript pour faciliter son intégration web.

Pour obtenir de bons résultats sur ChatGPT Image, commencez par rédiger un prompt clair et détaillé (style, ambiance, couleurs, format). Ajoutez une image de référence si vous voulez un rendu fidèle, ou utilisez l’option d’édition pour corriger directement un détail.

ChatGPT Agent est une option récente qui permet à l’IA d’agir de manière autonome grâce à un ordinateur virtuel intégré. Il peut naviguer sur le web, analyser des données, modifier des fichiers ou encore interagir avec des applications. L’objectif est de créer un assistant proactif, capable de réaliser des tâches complexes en suivant vos instructions.

Atlas est le navigateur boosté à l'IA d'OpenAI. Son objectif : vous permettre d'utiliser ChatGPT directement depuis votre navigateur, sans avoir à jongler entre de nombreux onglets. Et avec l'Agent Atlas, vous pouvez même déléguer certaines tâches chronophages à votre navigateur. Bref, avec Atlas, OpenAI a voulu réunir tous les ingrédients pour vous aider à gagner un temps précieux au quotidien.