Classement des 10 meilleures Licences & Bachelor IA en 2026

Découvrez notre classement des 10 meilleures licences et bachelors en IA disponibles en 2026 pour étudier l'intelligence artificielle après le bac.

Téléchargez le programme de nos formations

Téléchargez le rapport d’insertion 2025

Selon Amélie Raoul, chercheuse en intelligence artificielle et ambassadrice de Jedha AI School, « l'éthique de l'intelligence artificielle, c'est faire en sorte que l'IA serve le bien-être humain et préserve les droits fondamentaux ». Cette sous-branche de l’intelligence artificielle vise ainsi à s’assurer que les systèmes d’IA agissent selon des principes moraux clairs : transparence, équité, responsabilité, sécurité, respect de la vie privée et de la propriété intellectuelle.

Plutôt que « d’éthique de l’IA », il faudrait d’ailleurs plutôt parler « d’éthique appliquée à l’IA », car l’intelligence artificielle étant une machine, elle ne peut en elle-même être éthique. Plus que de rendre les machines morales, l’idée de l’éthique appliquée à l’IA est donc plutôt de responsabiliser les humains qui les conçoivent et les utilisent.

À mesure que l’intelligence artificielle évolue, elle s’invite partout, même dans les secteurs sensibles, comme le médical, la justice ou encore la politique. Une part croissante de décisions, parfois critiques, reposent ainsi sur des algorithmes.

Mais ces algorithmes sont loin d’être infaillibles, et ils peuvent même être biaisés. D’un côté, les critères qui orientent leurs décisions restent souvent opaques. De l’autre, avec la popularisation de l’IA générative, il est désormais possible de créer rapidement des outils très puissants. Résultat, ces derniers mois, ces outils se sont glissés dans tous les aspects de notre vie (personnelle, professionnelle et citoyenne) sans forcément que nous ayons pu réfléchir à leurs impacts. Et les problèmes se manifestent déjà, puisque certains n’hésitent pas à les détourner à des fins malveillantes (propagation de fake news, deepfakes…).

Bref, tous les ingrédients sont réunis pour obtenir un cocktail explosif qui alimente les débats autour de l’éthique appliquée à l’IA, mais surtout, qui suscite la méfiance vis-à-vis de ces nouvelles technologies. Or, cela représente une menace vitale pour l’industrie naissante de l’IA générative.

Pourquoi ? Parce que, comme le souligne Antoine Krajnc, expert en Machine Learning et fondateur de Jedha, « l’éthique de l’IA, c’est avant tout une question de confiance : si je ne peux pas avoir confiance dans l’outil, je ne l’utiliserai pas ». Les entreprises de l’IA comme OpenAI, Google Deepmind ou Anthropic ne parviennent pas à rassurer quant à l'éthique de leurs modèles, l’adoption et le déploiement de l’IA générative risque donc d’en pâtir.

Les débats sur l’éthique de l’IA n’interviennent donc pas pour freiner le progrès, mais pour l’encadrer intelligemment et s’assurer que ces technologies aient un impact positif sur nos sociétés.

Malgré les prises de conscience, nous avons encore de nombreux progrès à faire en ce qui concerne l’éthique appliquée à l’IA. Et les chiffres parlent d’eux-mêmes : si la plupart des entreprises européennes reconnaissent l’importance de ce sujet, seule une sur trois a adopté une politique d’IA responsable.

Principale raison évoquée ? Le manque de professionnels capables de les guider. À ce propos, Amélie Raoul estime d’ailleurs que « dans les années à venir, le métier d'Éthicien de l'IA va devenir quasi obligatoire dans certaines entreprises ». Un métier d’avenir à surveiller de près, donc.

L’éthique de l’IA touche à des enjeux très concrets qui influencent déjà nos vies. Parmi eux, vous trouverez l’équité, le respect de votre vie privée et de la propriété intellectuelle, la transparence, la menace de la désinformation, la sécurité, et même l’impact environnemental de l'IA.

Le principal problème des algorithmes, c’est qu’ils s’entraînent sur des données humaines, données par nature biaisées. Résultat : les IA génératives reproduisent souvent dans ce qu’elles génèrent les inégalités et les injustices que l’on connaît dans nos sociétés.

Amélie Raoul l’explique d’ailleurs bien en prenant l’exemple d’un outil de tri de CV développé par Amazon et utilisé de 2014 à 2015. Son modèle avait été entraîné sur des CV récoltés en interne depuis 10 ans, et qui appartenaient majoritairement à des hommes (qui, encore plus à l’époque, sont plus nombreux dans le secteur de la tech). Résultat : l’algorithme a appris à préférer les CV masculins et à pénaliser systématiquement ceux appartenant à des femmes.

Une IA peut ainsi institutionnaliser les discriminations à grande échelle, et ce, dans de nombreux domaines (recrutement, accès au crédit, justice, éducation…). Pour l’éviter, il est essentiel que les humains contrôlent les systèmes d’IA pour détecter et corriger ces biais, et utilisent dès le départ des datasets diversifiés pour les entraîner.

Pour pouvoir être les plus efficaces possibles, les modèles d’IA ont besoin d’être entraînés sur d’immenses quantités de données.

Le problème, c’est que les données librement utilisables ne sont pas disponibles en quantité infinie. Une fois épuisées, il est ainsi malheureusement courant que ces modèles soient entraînés sur des données non-libres de droits telles que :

Le développement de l’IA met ainsi en péril nos données et notre vie numérique, ce qui pose de graves problèmes éthiques.

Comme le soulève Amélie Raoul, l’un des principaux problèmes des systèmes algorithmiques, c’est qu’ils manquent généralement de transparence. Ce problème s’accentue face à la multiplication de ces algorithmes dans des systèmes essentiels dans nos vies quotidiennes (Parcoursup, CAF, France Travail, systèmes de tri des CV, scoring bancaire…) qui se basent sur des critères obscurs pour prendre des décisions.

Or, sans transparence ni supervision humaine, il est impossible de faire confiance à une IA. Pour éviter la méfiance et les injustices, les concepteurs d’IA devraient ainsi expliquer les critères retenus par leurs algorithmes. De leur côté, il est important que les utilisateurs comprennent comment fonctionnent les systèmes automatisés pour les utiliser à bon escient et de ne pas subir leurs biais.

Vous le voyez avec la popularisation de l’IA générative, contrairement à il y a quelques années où cela demandait encore des compétences techniques, il est aujourd’hui très simple de créer des deepfakes photos et vidéos pour arnaquer des individus ou des entreprises, ou essayer de manipuler les opinions publiques. Pensez par exemple à cette dame qui, de 2023 à 2024, s’est fait extorquer plus de 800 000 euros par un faux Brad Pitt.

Or, comme le souligne justement Antoine Krajnc, « dès qu’on voit que l’IA est utilisée à mauvais escient, la confiance dans l’outil s’effrite. Les gens finissent par penser que tout ce que l’IA génère est nul ou dangereux, ils ne l’utilisent plus ». Si les concepteurs d’IA veulent assurer la pérennité de leurs outils, ils ont ainsi tout intérêt à essayer de limiter ces dérives. Mais comme en témoigne la sortie récente de Sora 2 et les nombreux deepfakes qui en ont découlé, il y a encore beaucoup de travail à faire à ce niveau-là, d’autant que cela peut être compliqué à réguler :

En théorie, des garde-fous empêchent les IA d’aller trop loin. Le problème, c’est qu’ils sont encore rarement assez robustes et qu’il est donc possible de les contourner (c’est ce que l’on appelle le jailbreak). Et cela peut conduire à des résultats désastreux, en témoigne le suicide d’un adolescent américain, que ChatGPT a encouragé à passer à l’acte. Des garde-fous étaient certes en place, mais loin d’être suffisants, ils n’ont pas pu empêcher cet évènement tragique.

Sans mesures de sécurité renforcées, une IA peut ainsi devenir un véritable outil de nuisance. Il est donc important de les auditer régulièrement et de les superviser pour s’assurer que les mesures de sécurité en place sont suffisamment fortes, protègent les systèmes des cyberattaques, mais également des usages à risque.

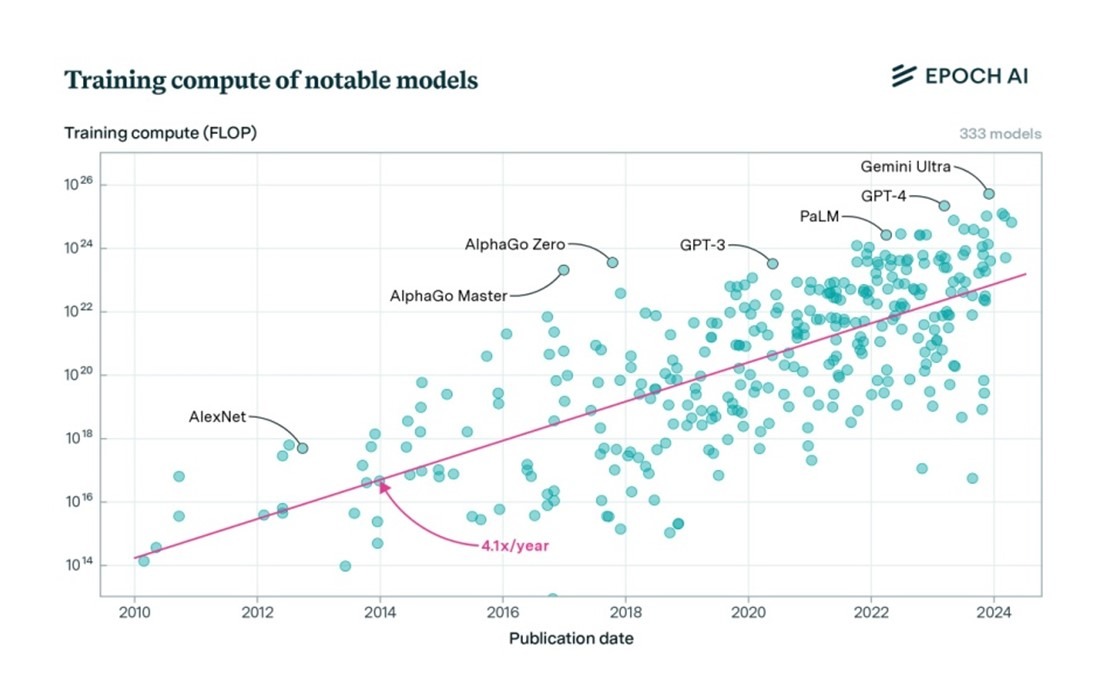

L’une des critiques souvent faite à l’IA, c’est qu’elle consomme énormément d’énergie, ce qui est extrêmement gênant alors que l’urgence est à la transition écologique. Cette consommation est notamment liée à la puissance des modèles les plus récents qui s’appuient sur des dizaines (voire des centaines) de milliards de paramètres pour fonctionner. Or, ce nombre ne cesse de croître à mesure que les modèles se perfectionnent, ce qui donne lieu à des dépenses énergétiques de plus en plus importantes. Par exemple, s’il est compliqué d’obtenir des informations officielles à ce sujet, plusieurs sources estiment néanmoins que GPT-4, basé sur 1,8 trillion de paramètres, consommerait 20 fois plus d’énergies que GPT-3, qui n’était « que » basé sur 175 milliards de paramètres (soit 0,175 trillion)

Source : itsocial.fr

En attendant que des progrès soient faits à ce sujet, il est important de réfléchir à nos usages et d’utiliser l’IA de manière raisonnée. Comme le souligne Antoin Krajnc, « est-ce logique d’utiliser un modèle gigantesque pour une tâche minime, comme générer des recettes de cuisine ? ». Plutôt que de vouloir absolument utiliser les modèles les plus perfectionnés, préférez ceux adaptés à vos besoins réels, qui seront souvent plus sobres et moins coûteux à faire tourner.

C’est le principe de l’IA frugale : concevoir des systèmes plus légers, plus efficaces et moins gourmands en énergie.

Si elle a un temps évolué dans une sorte de Far West numérique, l’intelligence artificielle tend de plus en plus à être régulée pour limiter les dérives, protéger les citoyens, et responsabiliser les organisations. Mais à ce sujet, toutes les régions du monde ne sont pas logées à la même enseigne.

L’Union européenne a ouvert la voie avec l’IA Act, adopté en 2024. Première régulation mondiale dédiée à l’intelligence artificielle, elle classe les systèmes selon leur niveau de risque (minimal, limité, élevé ou inacceptable). Les plus dangereux (outil de surveillance de masse, système de notation sociale…) sont interdits, et ceux à haut risque doivent faire l’objet d’audits, de certifications et de contrôles renforcés.

En France, la CNIL veille à ce que les usages de l’IA respectent les principes du RGPD (consentement, droit à l’explication, sécurité des données…), et peut infliger des amendes (pouvant atteindre 4 % du chiffre d’affaires mondial) aux entreprises d’IA françaises qui les enfreignent.

Ailleurs, les approches varient. Par exemple :

Enfin, en 2021, l’UNESCO a adopté une Recommandation sur l’éthique de l’IA. Bien que non-contraignant, ce texte, qui promeut le respect de valeurs universelles (notamment respect des droits humains, durabilité, équité et inclusion), a tout de même été approuvé par 194 pays.

Mais seuls, les textes ne suffisent pas. Sans une véritable culture éthique, même les meilleures lois resteront lettre morte. Pour qu’une régulation fonctionne réellement, il faut aussi sensibiliser à l’éthique, former et responsabiliser tous les acteurs de l’IA (chercheurs, développeurs, décideurs, utilisateurs).

.webp)

« L’éthique appliquée à l’IA, c’est un fil conducteur dans nos formations, pas un module isolé. » Cette phrase d’Antoine Krajnc, expert en IA et fondateur de Jedha AI School reflète parfaitement la philosophie de notre école. Peu importe leur cursus, tous nos élèves sont ainsi sensibilisés aux enjeux éthiques de l’intelligence artificielle.

Dès leurs premières semaines de formation, ils sont ainsi amenés à travailler sur des cas concrets, qui leur demandent aussi bien de faire des choix techniques que de faire attention aux implications éthiques de leurs projets. Ils apprennent rapidement à se poser les bonnes questions : est-ce que le modèle présente des biais ? comment sont traitées les données ? est-ce que les utilisateurs comprennent les décisions prises ?

Le fondateur de Jedha AI School le résume très bien : « chez Jedha, nous voulons vous transmettre les clés pour que vos projets d’IA puissent inspirer la confiance ». Notre objectif est donc clair : nous ne cherchons pas seulement à former des techniciens, mais des personnes capables de réfléchir aux implications de ce qu’ils construisent.

Le besoin en professionnels de l’éthique appliquée à l’IA risque de croître de façon exponentielle dans les prochaines années. C’est pour cela qu’au-delà de l’intégration de ces enjeux à l’ensemble de nos parcours, chez Jedha AI School, nous vous proposons également un parcours complet de bac à bac+5 entièrement dédiées à la stratégie, la gouvernance et l’éthique de l’IA :

À travers notre Bachelor Chef de projet & éthique de l’IA, nous formons des professionnels capables de piloter des projets IA tout en garantissant leur conformité éthique, sociétale et réglementaire.

L’objectif de notre Mastère Expert en Stratégie, Gouvernance & éthique de l’IA, c’est de former les futurs leaders qui seront capables de définir les grandes orientations IA des organisations, et de mettre en place une politique de gouvernance responsable.

Si vous cherchez un métier de l’intelligence artificielle qui intègre une forte dimension éthique, plusieurs rôles pourraient vous intéresser :

Les salaires des professionnels de l’IA sont parmi les plus élevés de la tech, et c’est également vrai pour ceux qui se spécialisent dans l’éthique. Ces métiers étant récents, il est cependant difficile de trouver des données détaillées, mais en moyenne, en France :

À l’international, ces rémunérations sont encore plus intéressantes. Aux États-Unis par exemple, un Éthicien généraliste gagne en moyenne entre 111 000 et 168 000 $ par an.

Si vous cherchez un métier d’avenir, le domaine de l’IA éthique vous offre de nombreuses possibilités, puisque dans les années à venir, les entreprises vont avoir de plus en plus besoin de professionnels capables de concevoir des technologies au service du bien commun. Et chez Jedha AI School, nous vous formons justement à ces métiers, et vous donnons les clés pour penser l’IA autrement, de façon plus éthique, plus responsable et plus humaine. Pour nous rejoindre, rien de plus simple :

Plusieurs éléments peuvent être mis en place pour appliquer une politique d’IA éthique dans votre entreprise :

Les principes clés de l’éthique appliquée à l’IA sont :

Une IA inclusive est une IA qui a été conçue pour éviter les biais et prendre en compte la diversité des ses utilisateurs (genre, origine, âge, orientation sexuelle, handicap…). Son objectif est d’offrir les mêmes opportunités de traitement sans discriminer en fonction du profil des utilisateurs.